阿里云超算揭秘:虚拟机的心脏,物理机的肌肉

发布时间:2018-10-16 17:57

在汽车行业,过去有一句俗话,一辆车从设计到下线,“至少要11辆真实碰撞试验”,今天,在现代化的汽车制造业,通过长期发展的设计和仿真软件,几乎所有的环节,都可以做到设计与仿真一体化的高性能计算实现,这一进步的背后需要依赖更强的并行计算集群和灵活的数据流动,以及实现复杂算法的工业仿真软件。

2018杭州云栖大会主论坛上,阿里云高性能计算发布环节对比演示了风洞汽车模型实验和数字仿真风洞,吸引了现场以及线上众多观众的眼球。

展示环节首先通过风洞装置模型,现场以烟流法的方式展示了在不同风速条件下烟流经过模型车的不同轨迹,解释了传统汽车风洞实验的大致流程,并且大幅提升了测试效率。

这次演示背后的两大核心是SCC超级计算集群和E-HPC:使用阿里云SCC超级计算集群,结合E-HPC创建集群及集谛性能分析等操作流程,以可视化的形式展示ANSYS流体动力学软件基于SCC和E-HPC弹性高性能计算服务进行求解运算后的结果。

/云上超级计算集群SCC/

现场进行ANSYS Fluent F1赛车模型流体动力仿真计算的HPC集群计算节点由超级计算集群scch5实例组成。

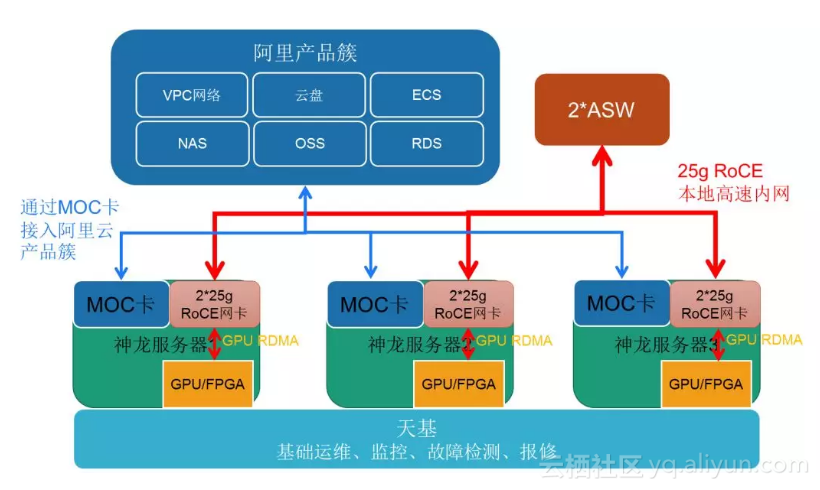

SCC基于阿里云新一代弹性裸金属(神龙)服务器,既具备了云计算的弹性资源优势,又拥有了物理机的性能,在此之上加入高速RDMA互联支持,大幅提升网络性能,显著提高大规模集群加速比,这也是SCC独有的特点。

如果用公式表达的话:SCC = 弹性裸金属服务器+ RDMA网络;总结一句话就是,SCC拥有虚拟机的心脏,物理机的肌肉,高速的神经。

弹性裸金属服务器(ECS Bare Metal Instance)计算性能与传统物理机无差别,具有安全物理隔离的特点。

RDMA(Remote Direct MemoryAccess)是一种直接存储器访问技术,它将数据直接从一台计算机的内存传输到另一台计算机,无需双方操作系统的介入。这允许高通量、低延迟的网络通信,尤其适合在大规模并行计算机集群中使用,SCC使用的是RDMA 的方案之一——RoCE网络。

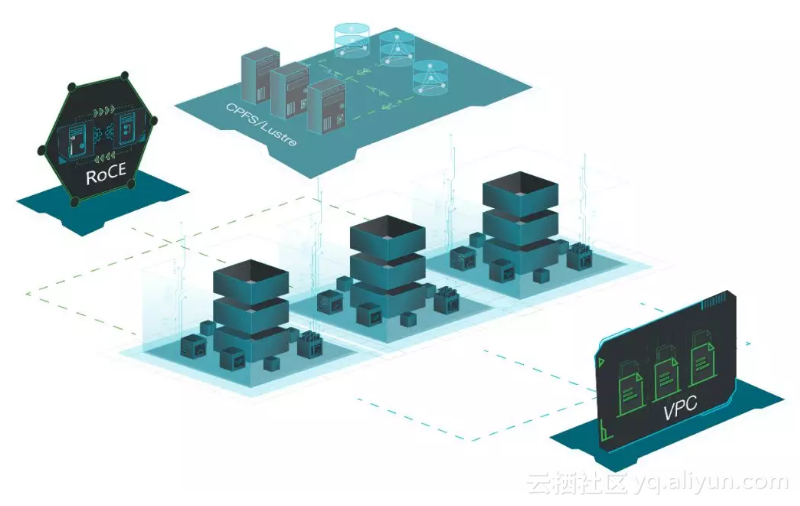

同时SCC还与成熟的ECS管控完整对接,确保了用户体验一致性,且与阿里云VPC网络、NAS共享文件存储、CPFS高性能共享存储等产品完全整合,充分发挥云上生态优势,带来极致的计算体验。

/弹性高性能计算E-HPC/

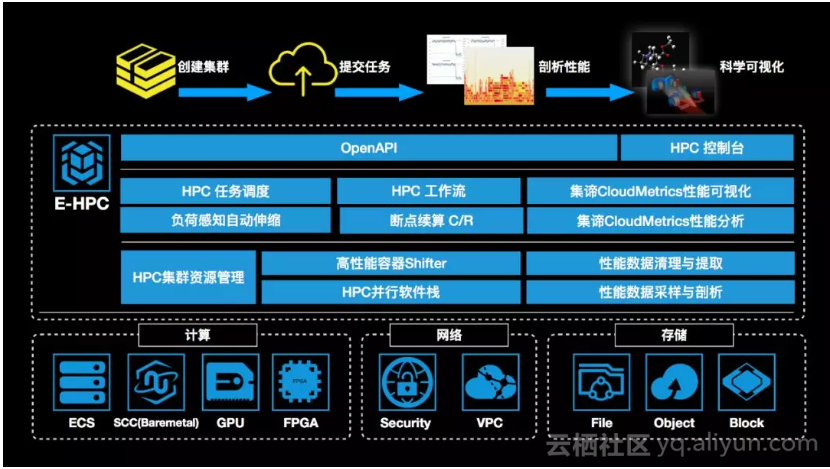

如果说SCC提供的是高性能计算基础设施,那么E-HPC则为用户提供了一站式全业务流程的公共云HPC服务。

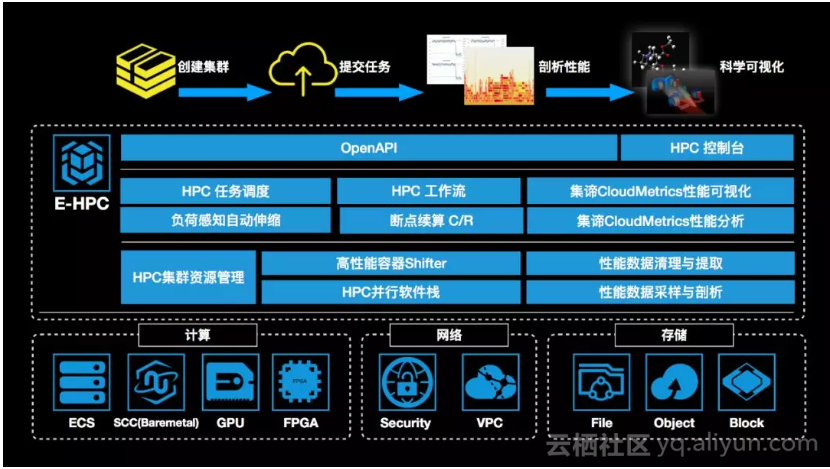

E-HPC通过集成PBS pro/Slurm等HPC调度器提供了并行调度功能,基于阿里云管控能力实现了根据负载进行集群规模自动伸缩,基于VPC网络及RoCE网络架构提供了并行通讯支持,由超算容器Shifter提供了容器部署功能,专门针对云上并行作业开发的集谛提供了性能监控分析和“性能大数据”积聚优化引擎。

在演示中,E-HPC提供了并行调度,自动扩容和并行通讯支持,使得大规模仿真成为可能。

相比传统超算中心以及自建IDC集群,E-HPC的优势也很明显:1、相比传统超算中心,E-HPC可按需购买,无需排期,即买即用;实例种类多,可根据应用需求购置最适合的计算资源配比;充分复用阿里云产品,大大提高了数据安全性和高可用性。2、相比自建IDC集群,E-HPC 可节约巨量 CAPEX 投入,包括但不限于硬件系统费用,软件许可证费用 (如ANSYS支持云上elastic license),服务器机房建设,电力和制冷费用,平日运作的维护支持费用等,而且无需顾虑硬件升级换代,公共云确保了极强的可扩展性。

目前,阿里云HPC已经广泛应用于制造业以及科学计算等领域:

1、上汽集团乘用车采用SCC集群进行混合仿真,整体提升25%效率;

2、安世亚太基于SCC集群为客户提供HPC解决方案,总体成本下降20%以上;

3、大连化物所国家重点实验室使用E-HPC集群做分子动力学仿真计算,相对上一代GPU集群效率提升200% 。